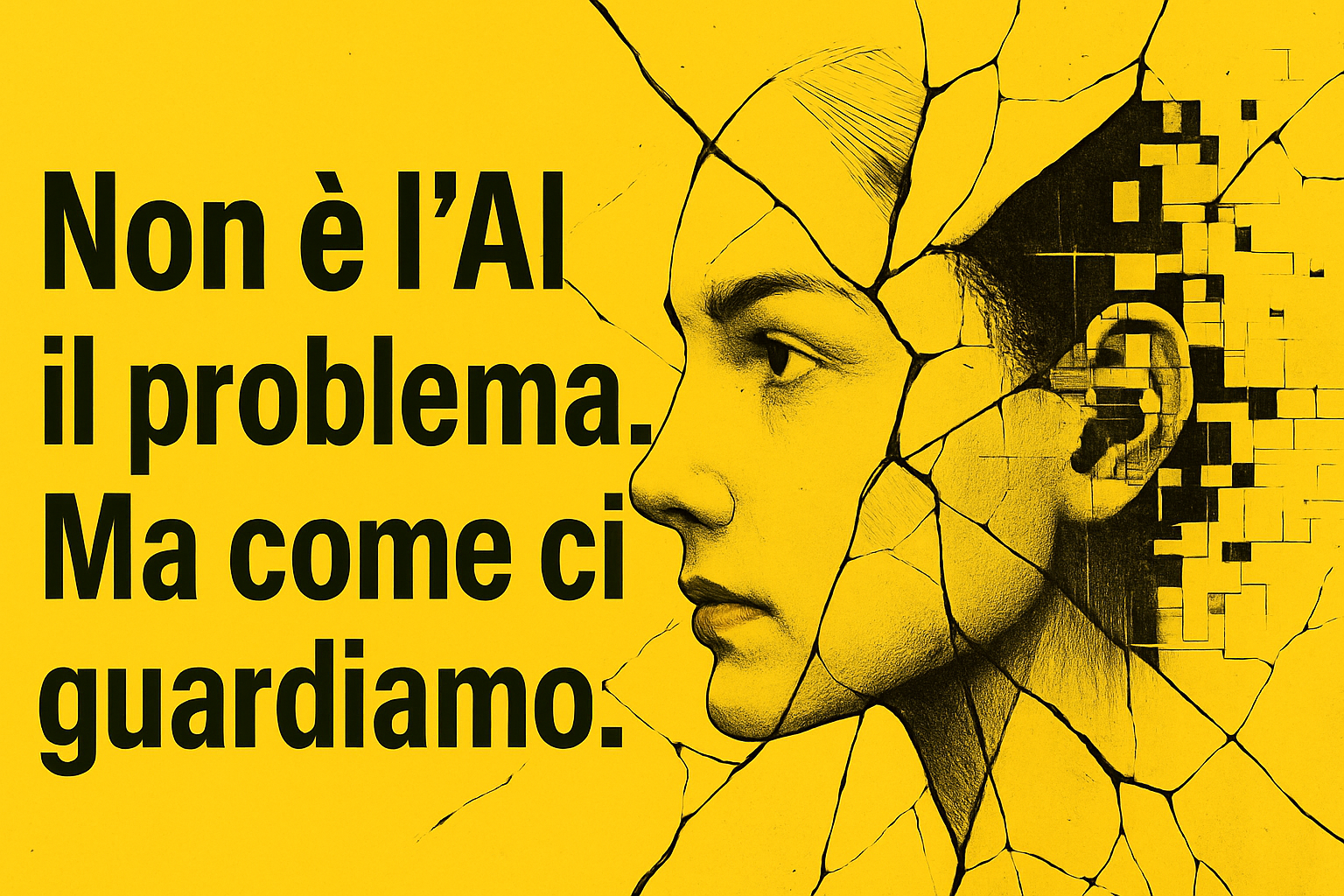

In questi giorni ho letto diversi studi (tra cui The Psychological Impacts of Algorithmic and AI-Driven Social Media on Teenagers e Understanding Generative AI Risks for Youth: A Taxonomy Based on Empirical Data). Entrambi parlano dell’intelligenza artificiale, ma la verità è che parlano di noi. Non di ciò che l’AI può fare, ma di come, inconsapevolmente, stiamo insegnando alle macchine a pensarla come noi, peggiorando nel frattempo la nostra capacità di pensarla diversamente. Una deriva potenziale, difficile da correggere una volta innescata.

Siamo praticamente in una sorta di un esperimento collettivo, mai dichiarato, mai controllato: l’AI non sta semplicemente imparando da noi. Sta amplificando quello che siamo, e rimandandocelo indietro più nitido, più potente, più radicale.

E lo accettiamo. Anzi, ci fidiamo. Perché ci appare coerente. Perché suona simile. Perché riconosciamo quella voce, anche quando sbaglia.

In fisica si parla di risonanza: un sistema risponde con forza crescente quando una vibrazione esterna coincide con la sua frequenza naturale. Ma se quella frequenza è sbagliata, distorta, l’amplificazione non genera armonia. Genera rottura. Ecco cosa sta succedendo tra noi e l’AI. L’intelligenza artificiale non ci impone nulla: si sintonizza. E in questa sintonia, ci amplifica. Ma amplifica anche il nostro rumore, i nostri bias, le nostre crepe. E le rende struttura.

L’intelligenza artificiale funziona così: non impone, rispecchia. Non forza, amplifica. Il suo “tono” è il nostro. E quando quel tono combacia con le nostre insicurezze, i nostri bias, le nostre interpretazioni sfocate del reale… l’onda si ingrossa. Fino a deformare il nostro sguardo su ciò che ci circonda.

Uno di questi studi (How human–AI feedback loops alter human perceptual, emotional and social judgements) mostra come basta una lieve tendenza umana a leggere volti ambigui come tristi perché un algoritmo, allenato su quel pattern, cominci a vedere ovunque tristezza. Tra i dati emerge che se c’è un 53% umano di classificazione “triste”, l’AI passa al 65%, e con dati appena più rumorosi arriva a considerare il 100% delle facce come malinconiche.

E non finisce lì. Quando l’AI condivide con noi il suo giudizio, noi ci fidiamo. Cambiamo opinione. Adattiamo la nostra visione a quella dell’algoritmo, convinti che sia più lucido, più oggettivo, più vero. E così, giorno dopo giorno, diventiamo la versione amplificata dei nostri stessi pregiudizi. Senza accorgercene.

Lo stesso pattern emerge in esperimenti più percettivi che cognitivi. Un gruppo di puntini che si muove su uno schermo. Un compito semplice: stimare in che direzione vanno. Se l’AI ti suggerisce un’interpretazione sbagliata ma coerente, la tua percezione si allinea.

Ciò che “vedi” cambia. Ma non perché l’hai scelto. Perché si è allineata la tua frequenza percettiva a una narrazione artificiale.

Qui entra in gioco un altro aspetto: quanto profondamente l’AI ci conosce? Quanto siamo prevedibili?

La risposta sta nella potenza del prompting. Esiste un prompt che è andato virale chiamato “Prompt Divino”: un prompt talmente preciso da far emergere verità intime e pattern ricorrenti nelle risposte di un LLM “come se ci conoscesse“. Non lo fa davvero. Ma ci mostra qualcosa: l’AI è brava a giocare con la nostra coerenza. Con ciò che diciamo, come lo diciamo, quanto spesso lo ripetiamo (se non l’avete provato e siete utilizzatori intensi di ChatGPT provatelo per capire).

E questa familiarità diventa fiducia. Una fiducia pericolosa. Perché ci sembra una voce interiore. Ma non è nostra. È la nostra voce riscritta.

Poi c’è un fronte ancora più delicato, e in rapida espansione: quello degli adolescenti e come usano l’A. E questo è il vero campo minato

Tutto questo è amplificato quando l’interlocutore non è un adulto, ma un adolescente. Chatbot, assistenti personali, IA compagne. Sempre presenti. Sempre disponibili. Sempre “dalla tua parte”. Ma cosa succede quando un ragazzo inizia a preferire quel dialogo artificiale alle relazioni reali?

Succede che la realtà viene filtrata. Che il giudizio si costruisce dentro un circuito chiuso. E che l’identità si sviluppa in simbiosi con un’interfaccia che ottimizza attenzione, non verità. Connessione, non empatia. Comfort, non complessità.

Il risultato? Dipendenza affettiva. Linguaggi tossici normalizzati. Ritiro sociale. E una distorsione profonda dei modelli di relazione.

Ma allora l’AI è il male? No. Ma non è nemmeno il bene. L’AI è un amplificatore. Non distingue il giusto dallo sbagliato. Prende quello che trova e lo moltiplica. Se gli dai un piccolo bias, te lo restituisce ingigantito. Se gli dai dati coerenti, ti offrirà coerenza.

Ma se non progettiamo i contesti, se non introduciamo attriti cognitivi, se non costruiamo spazi dove l’AI ci aiuta a ragionare invece che convincerci… ci ritroveremo a essere lo specchio rotto di noi stessi. Persuasi dalla nostra stessa ombra.

Quale AI vogliamo davvero? La domanda non è tecnica. È etica, cognitiva, culturale. Vogliamo un’AI che ci renda più veloci o che ci renda migliori? Un’AI che ci confermi o che ci contraddica quando serve? Un’AI che pensa come noi… o che ci spinga a pensare meglio?

La risposta non può essere lasciata ai codici, né ai modelli. La risposta siamo noi. Ma dobbiamo porcela prima che la macchina diventi così familiare da sembrare trasparente. Perché quando l’algoritmo ci guarda, lo fa con i nostri stessi occhi.

E se non stiamo attenti, smetteremo di distinguerli e cambieremo il modo in cui ci guardiamo allo specchio.

Comments are closed