Qualche giorno fa, discutendo con un cliente, parlavamo delle evoluzioni e delle potenzialità oggi di approcciare il mercato come un ecosistema di connettori che possiamo abilitare – o che ci abilitano – a fare cose che, probabilmente, da soli non potremmo mai fare. Un approccio non più basato sull’idea di costruire tutto in casa, ma sulla capacità di orchestrare elementi esterni, modulari, interoperabili. Di connettere e collaborare. Di espandere le proprie possibilità attraverso la rete, e non dentro un perimetro chiuso.

È un po’ come passare da una barca a remi a una barca a vela: con i remi sei autonomo, ma limitato; con la vela, se impari a usare il vento giusto e a orientarti con gli strumenti, puoi fare molta più strada. Ma da solo non basta il vento: serve un sistema che lo intercetti, che lo traduca in movimento, che funzioni in modo integrato. I connettori sono quel sistema.

Nel mondo dell’intelligenza artificiale questo concetto è sempre più attuale. L’AI non può più vivere in isolamento, dentro modelli chiusi e dataset statici. Per essere davvero utile, deve dialogare con il mondo reale: accedere a informazioni, attivare strumenti, collaborare con altri sistemi. È qui che entra in gioco un paradigma nuovo e promettente: quello del Model Context Protocol (MCP).

Un protocollo che non riguarda solo la tecnica, ma il futuro del modo in cui costruiamo applicazioni intelligenti, abilitando una logica di AI plug-and-play, distribuita, connessa.

Visto che più persone mi hanno chiesto di spiegarlo, ne ho scritto in modo approfondito qui sotto, prendendomi un po’ di giorni per preparare tutto, provando ad analizzarne le implicazioni tecniche e strategiche. Buona lettura.

Benvenuto MCP

Model Context Protocol (MCP) è un protocollo aperto pensato per collegare i modelli di linguaggio di grandi dimensioni (LLM) e gli assistenti AI al “mondo esterno” – che siano file, database, servizi web o applicazioni aziendali . In pratica funziona come un adattatore universale (spesso paragonato a una porta USB-C) per le applicazioni AI, fornendo un modo standard per “plug-and-play”: invece di costruire integrazioni ad hoc per ogni singola fonte dati o strumento, con MCP l’assistente AI può connettersi in modo uniforme e sicuro a qualsiasi sistema esterno autorizzato .

Questa è un’innovazione cruciale perché finora anche gli AI assistant più avanzati operavano in una sorta di bolla isolata: ogni volta che volevamo dare accesso a un modello AI a informazioni aziendali (es. il CRM clienti o il repository di codice) bisognava predisporre una soluzione su misura, spesso complessa e poco riutilizzabile . MCP nasce proprio per superare questo collo di bottiglia, standardizzando come le applicazioni forniscono contesto e dati agli LLM . Sviluppato inizialmente da Anthropic (la squadra dietro Claude) e rilasciato come standard aperto verso la fine del 2024, MCP promette di mettere ordine nel frammentato panorama delle integrazioni AI, offrendo alle organizzazioni un approccio condiviso e modulare per connettere i propri sistemi alle capacità dei modelli generativi.

Per capirci, anche senza scrivere codice da zero, oggi è possibile avviare un MCP server in pochi minuti. Tool come Claude Desktop o l’editor Cursor lo supportano nativamente, e permettono agli sviluppatori di testare connettori reali – come lettori di file o scraper web – direttamente dalla propria interfaccia AI preferita.

Architettura tecnica: come funziona MCP

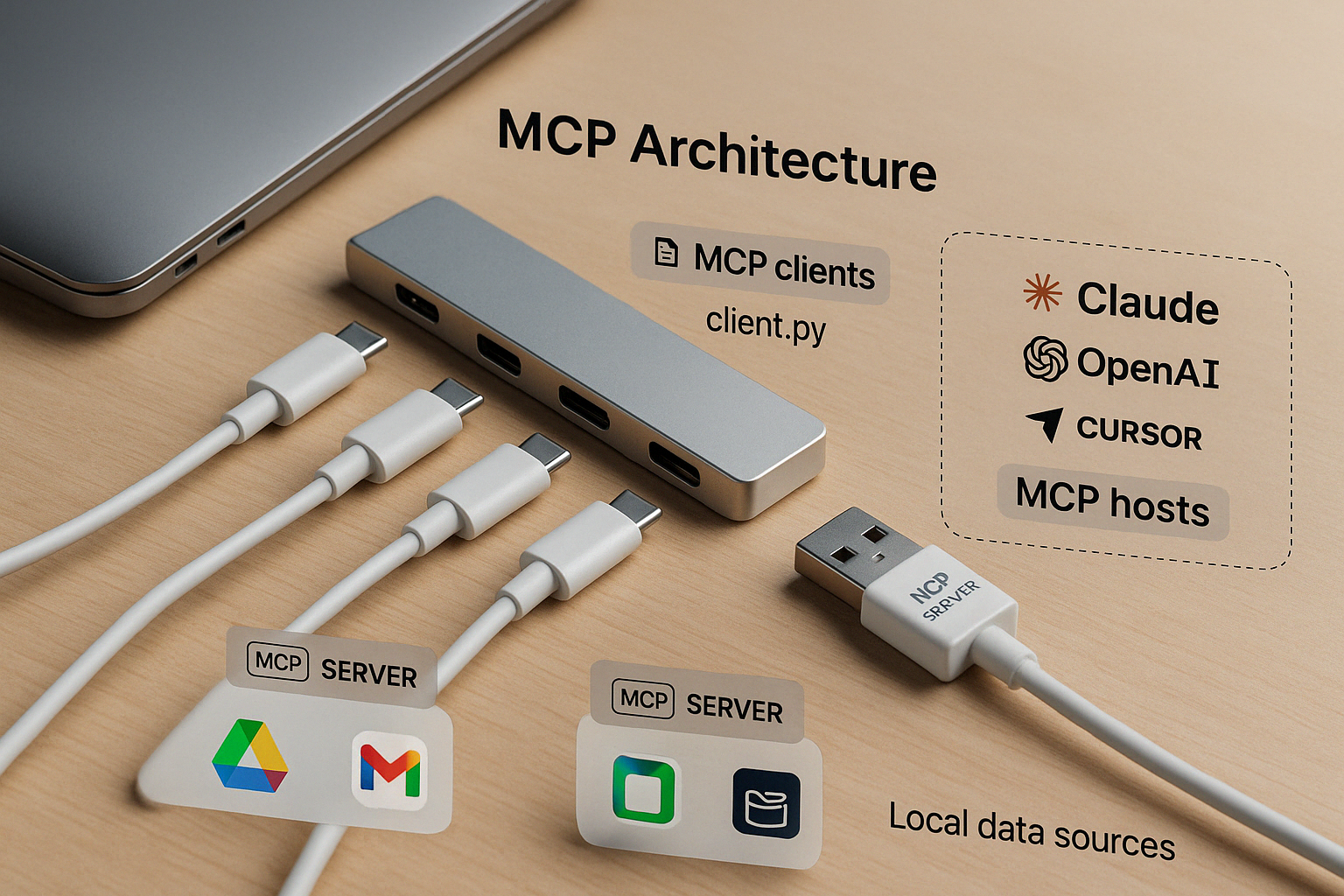

MCP segue un’architettura client-server tradizionale, adattata al contesto degli LLM. In sintesi, un’applicazione host dotata di un client MCP può collegarsi (anche simultaneamente) a più server MCP dedicati, ognuno esponendo un set di dati o funzioni specifiche . Questa suddivisione consente di mantenere separati i ruoli e semplificare l’integrazione. I componenti chiave dell’ecosistema MCP sono:

-

MCP Host – L’applicazione o agente AI che necessita di funzionalità contestuali. Può trattarsi di un chatbot, di un’assistente in un’app desktop (es. Claude Desktop) o di un’IDE potenziata con AI. Il host integra un client MCP per poter accedere a dati esterni tramite il protocollo .

-

MCP Client – Il modulo (tipicamente una libreria software) incaricato di gestire la connessione 1:1 con un server MCP. Il client traduce le richieste dell’host in messaggi MCP standard, si occupa del trasporto (es. via WebSocket, RPC locale, ecc.) e gestisce l’autenticazione e i permessi verso il server . In pratica, è il “connettore” che collega l’assistente AI ai vari server MCP.

-

MCP Server – Un programma leggero che espone una o più risorse o tool attraverso l’interfaccia standard MCP. Ciascun server in genere collega il mondo AI a una specifica fonte di informazioni o servizio: ad esempio un server MCP potrebbe dare accesso a un database, a un repository di documenti, a un’API esterna (es. meteo, CRM) o a strumenti come un motore di ricerca interno . Il server implementa le funzionalità richieste (lettura file, esecuzione di query, invio di email, ecc.) presentandole al modello in modo unificato.

-

Fonti di dati locali – Sono le risorse presenti nell’infrastruttura locale dell’utente o azienda: file system, database interni, applicazioni self-hosted, ecc. I server MCP possono accedere a queste fonti in sicurezza, applicando permessi granulari affinché il modello possa vedere solo ciò che è autorizzato . Ad esempio, un server MCP potrebbe offrire accesso in sola lettura a una cartella di documenti, senza esporre altri file sul computer.

-

Servizi remoti – Sono sistemi esterni accessibili via rete (Internet) tramite API o SDK: servizi SaaS, piattaforme cloud, tool di terze parti. Un server MCP funge da bridge sicuro anche verso queste risorse . Ad esempio, un connettore MCP potrebbe interfacciarsi con le API di Salesforce, di Google Drive o di un servizio di eCommerce, rendendo disponibili al modello operazioni su quei servizi senza che l’LLM debba conoscere i dettagli delle API.

Grazie a questa architettura modulare e componibile, un’app AI può attingere a diversi server MCP in parallelo mantenendo un’interfaccia coerente. Il host (l’assistente AI) continua a concentrarsi sul dialogo e sul ragionamento in linguaggio naturale, delegando al client MCP la gestione tecnica delle chiamate, mentre i server MCP si occupano dell’accesso ai dati e alle azioni nei rispettivi domini . Questo separa le responsabilità in maniera pulita: l’assistente AI “chiede” e interpreta, i server “eseguono” e forniscono risultati, il tutto orchestrato tramite un linguaggio comune definito dal protocollo.

Da un punto di vista implementativo, MCP definisce un insieme di messaggi standard (richieste, risposte e notifiche) in formato JSON-RPC, insieme a concetti come Risorse (documenti o dati identificabili da ID), Tool (funzioni invocabili dal modello, ad es. createNewTicket per aprire un ticket) e Prompt (template di prompt predefiniti) . Ciò significa che quando il modello “vuole” eseguire un’azione (per esempio leggere un file o ottenere un report meteo), il client MCP invia una richiesta standardizzata al server appropriato, il quale la elabora e risponde con i dati richiesti, il tutto secondo regole uniformi. Questo schema riduce le ambiguità e facilita sia lo sviluppo che il debugging, perché ogni integrazione segue lo stesso protocollo di comunicazione.

Vantaggi di MCP rispetto alle integrazioni tradizionali

L’adozione di un protocollo unificato come MCP porta numerosi benefici rispetto alle integrazioni custom costruite ad hoc. Di seguito evidenziamo i vantaggi principali – standardizzazione, modularità, sicurezza e riusabilità – che rendono MCP un passo avanti decisivo:

-

Standardizzazione – MCP fornisce un’interfaccia comune per collegare LLM e fonti esterne, eliminando la necessità di interfacce proprietarie o API disparate per ogni sistema . Invece di dover gestire formati e modalità diverse (un plugin per i documenti, un altro per il CRM, ecc.), con MCP tutte le integrazioni seguono lo stesso schema. Ciò riduce la complessità e gli errori: gli sviluppatori non devono più “reinventare la ruota” ogni volta, ma possono affidarsi a pattern consistenti per accesso ai dati, esecuzione di tool e gestione dei prompt . In breve, MCP crea un linguaggio comune tra AI e servizi, dove prima regnava la frammentazione.

-

Modularità e flessibilità – Con MCP, ogni fonte di dati o servizio esterno diventa un modulo separato (un server MCP) che può essere aggiunto o rimosso senza impattare il resto del sistema. Questo approccio plug-and-play consente di combinare facilmente più integrazioni: ad esempio, si possono attivare server MCP per Slack, per un database SQL e per un servizio meteo indipendentemente, e l’assistente AI li scoprirà tutti tramite il medesimo protocollo . La modularità semplifica la manutenzione: ogni connettore è isolato, e aggiornare o correggere uno non rischia di rompere gli altri. Inoltre favorisce la condivisione: la community sta già costruendo una libreria crescente di server MCP predefiniti (per Slack, database, Gmail, ecc.), pronti all’uso . Questo ecosistema modulare permette anche a organizzazioni diverse di riutilizzare lo stesso connector per un certo servizio, evitando duplicazioni di sforzo.

-

Sicurezza e controllo – Uno dei vantaggi chiave di MCP è l’attenzione alla sicurezza integrata. Il protocollo supporta autenticazione e permessi granulari nativamente: il client e il server negoziano cosa il modello può o non può fare, con la possibilità di limitare l’accesso in sola lettura, a specifiche cartelle o a determinate azioni . Questo significa che un’azienda può permettere a un agente AI di consultare un database senza concedergli anche il potere di modificarlo, riducendo il rischio di incidenti o abusi. Inoltre, usando un unico layer di integrazione, diventa più semplice monitorare e loggare tutte le operazioni: invece di tracciare 10 API diverse, si può centralizzare l’audit nel server MCP, applicando in modo consistente le policy di sicurezza e conformità . In settori regolati (finanza, sanità) ciò è fondamentale, e MCP offre un punto unico dove implementare controlli e verifiche . Infine, eseguendo i server MCP nella propria infrastruttura, i dati sensibili rimangono sotto controllo diretto dell’azienda (o dell’utente) e non devono essere esposti a servizi terzi non fidati .

-

Riusabilità e interoperabilità – MCP è stato progettato per essere agnostico rispetto al modello e al fornitore: il protocollo funziona con qualsiasi LLM o ambiente, da GPT-4 a Claude o modelli open-source, e non vincola a uno specifico vendor cloud . Ciò scongiura il vendor lock-in: ad esempio, non serve sviluppare un plugin custom solo per una certa piattaforma proprietaria di chatbot, ma si può usare MCP in modo trasversale. I connettori realizzati una volta possono essere riutilizzati in molteplici applicazioni e con diversi modelli senza modifiche . Questo approccio “build once, use anywhere” aumenta l’efficienza e protegge l’investimento tecnologico nel tempo . Se domani si decide di passare a un altro provider di LLM o di integrare un nuovo tool, basterà pluggare il relativo server MCP senza riscrivere da zero l’integrazione. Inoltre la natura open di MCP incentiva una comunità di sviluppatori a contribuire con nuovi server e client, accelerando la creazione di un catalogo condiviso di integrazioni pronte all’uso .

Ambiti di applicazione di MCP

Le caratteristiche di standardizzazione e modularità di MCP abilitano un’ampia gamma di applicazioni, dal contesto individuale fino alle grandi imprese. Di seguito esploriamo alcuni scenari d’uso rappresentativi – personale, B2C e B2B/enterprise – per capire come questo protocollo può essere sfruttato in pratica.

- Assistenti personali e uso individuale : immaginiamo un assistente AI personale in grado di aiutare l’utente nelle attività quotidiane accedendo ai suoi dati in modo sicuro. Con MCP, un singolo assistente può connettersi a più fonti personali: ad esempio il calendario e la rubrica contatti, una collezione di note o documenti sul PC, le email o chat private (con il dovuto consenso). Attraverso connettori MCP preposti, l’LLM potrebbe leggere un appuntamento imminente, cercare un file nella directory dei documenti, o riassumere le email non lette – il tutto all’interno della stessa conversazione. Strumenti come Claude Desktop già consentono agli utenti di attivare server MCP locali per collegare l’assistente a file e applicazioni sul proprio computer , mantenendo i dati sotto il controllo diretto dell’utente. Questo scenario “Personal AI” diventa molto più fattibile grazie a MCP: l’utente avanzato può costruire (o installare dalla community) i connettori di cui ha bisogno, sapendo che l’assistente parlerà con tutti tramite un linguaggio unificato. Ad esempio, si può avere un server MCP per il proprio gestore di note, uno per il servizio di to-do list e uno per l’email; l’assistente li utilizzerà tutti insieme, intrecciando le informazioni da queste diverse fonti per fornire risposte e assistenza contestualizzata . Il risultato è un assistente davvero contestuale e multi-sorgente, capace di attingere a tutta la conoscenza personale disponibile in modo armonizzato, senza richiedere all’utente di ricorrere a plugin diversi per ogni funzione.

- Scenari B2C: e-commerce e customer support : nel mondo B2C, MCP apre la strada a esperienze cliente potenziate dall’AI. Si consideri un e-commerce che voglia offrire un assistente virtuale ai propri clienti: grazie a MCP, il bot potrebbe connettersi a tutte le fonti rilevanti per rispondere alle domande degli utenti e svolgere compiti utili. Ad esempio, mediante un server MCP collegato al database prodotti, l’LLM può recuperare in tempo reale dettagli di inventario, prezzi e specifiche tecniche per consigliare l’articolo giusto al cliente . Un altro connettore MCP potrebbe dare accesso allo storico ordini e al sistema di tracking spedizioni, così che l’AI assistant possa informare l’utente sullo stato del suo ultimo acquisto o avviare una procedura di reso. Tutto questo avviene tramite chiamate standard: il modello “chiede” ad MCP i dati necessari (es. getProductDetails o trackOrder) e riceve le risposte strutturate, senza dover navigare pagine web o affidarsi a conoscenze statiche. Per il cliente l’esperienza diventa quella di un dialogo naturale con un commesso virtuale sempre aggiornato, mentre l’azienda beneficia di una soluzione scalabile – può aggiungere nuove funzionalità semplicemente implementando un nuovo server MCP, magari per collegare un servizio di pagamento o un CRM marketing, senza dover riprogettare tutto il chatbot. In ambito customer support, analogamente, MCP consente a un assistente AI di attingere a knowledge base, FAQ aziendali e ticketing system simultaneamente . Un singolo agente virtuale può risolvere problemi consultando documentazione tecnica, controllando i dati del cliente (es. garanzie, configurazioni) e persino creando ticket di assistenza nel sistema IT, il tutto orchestrato via MCP in modo trasparente per l’utente finale. Questo livello di integrazione contestuale migliora significativamente la pertinenza e l’utilità delle risposte AI (riducendo anche il rischio di allucinazioni, poiché il modello si basa su dati verificati in tempo reale ), offrendo un servizio clienti più efficace e personalizzato.

- Integrazioni enterprise e agenti AI B2B : nel contesto enterprise e B2B, un protocollo standard come MCP può accelerare la trasformazione digitale rendendo più semplice portare l’AI dentro i processi aziendali. Ad esempio, un’azienda può sviluppare un AI agent interno che funge da assistente per i dipendenti, integrato con i vari sistemi aziendali: base di conoscenza interna, CRM, ERP, strumenti di collaborazione come Slack o Teams, ecc. Utilizzando MCP, un unico assistente conversazionale può: cercare informazioni nella wiki o intranet aziendale, estrarre dati da un database finanziario, creare o aggiornare ticket su Jira/ServiceNow, e persino interagire con la chat aziendale per notificare un collega – il tutto in sequenza, come parte di un flusso multi-step . Ad esempio, un agente AI per il supporto IT potrebbe analizzare la richiesta di un utente, recuperare log di errore da un sistema tramite un server MCP dedicato, aprire un ticket sul portale ITSM tramite un altro connector, e infine confermare all’utente la presa in carico, magari postando un aggiornamento su Slack . Senza un protocollo unificato, implementare questo tipo di flusso avrebbe richiesto di integrare separatamente ogni API e servizio, con molta logica di “colla” difficilmente riutilizzabile; con MCP invece l’agente utilizza comandi standard per scoprire e invocare ciascun tool necessario. Un altro caso d’uso B2B è nell’area vendite e business intelligence: si può avere un assistente AI che interroga il CRM o il data warehouse aziendale per ottenere indicatori aggiornati. Domande come “Quante vendite abbiamo fatto l’ultimo trimestre?” possono essere girate dall’LLM a un server MCP connesso al database di vendita, che ritorna il dato preciso al modello . L’assistente quindi fornisce la risposta al manager in linguaggio naturale, magari arricchendola di contesto (trend, grafici) se i connettori lo consentono. Questo trasforma il modo di accedere alle informazioni in azienda: non più dashboard separate e query manuali, ma conversazioni naturali con un AI abilitato a navigare tra diverse fonti aziendali istantaneamente. Infine, MCP risulta utile anche per costruire agenti AI specializzati per domini verticali – ad esempio nella sanità, un assistente per i medici potrebbe tramite MCP accedere sia ai protocolli clinici che al database dei pazienti (nel rispetto delle autorizzazioni), combinando entrambe le fonti per fornire una risposta accurata; oppure in ambito finanziario, un agente potrebbe reperire dati da sistemi di trading e documenti normativi per assistere un analista. In tutti questi casi, la chiave è la interoperabilità: MCP funge da livello unificante che rende possibile collegare in modo relativamente semplice molteplici sistemi eterogenei all’intelligenza artificiale, favorendo così l’adozione di soluzioni AI nei processi core dell’impresa.

Verso ecosistemi di agenti AI interconnessi

L’emergere di MCP riflette una tendenza più ampia nel mondo AI: passare da soluzioni isolate a un ecosistema connesso di agenti e servizi AI. Standard come il Model Context Protocol potrebbero diventare l’infrastruttura di base su cui si svilupperà un nuovo panorama di applicazioni intelligenti, dove diversi agenti AI e tool collaborano senza soluzione di continuità. Possiamo già intravedere alcune implicazioni evolutive di questa trasformazione:

-

Agenti più autonomi e tool-aware – Man mano che i modelli evolvono in direzione “agentica” (cioè capaci di intraprendere azioni autonomamente per raggiungere obiettivi), avranno bisogno di accedere a un arsenale di strumenti e fonti di conoscenza. MCP offre un directory standardizzato di capacità a cui un agente può attingere dinamicamente . Invece di essere limitato a ciò che è stato codificato staticamente, un LLM agent può scoprire quali server MCP sono disponibili (es. “posso leggere file X”, “posso invocare l’API Y”) e utilizzarli per portare a termine compiti complessi. Questo rende molto più semplice implementare workflow multi-passo e multi-strumento: l’agente può concatenare chiamate a vari connettori (database, gestione ticket, messaggistica) attraverso lo stesso protocollo unificato, senza dover gestire credenziali e API differenti per ciascuno . Il risultato sono agenti AI più capaci e proattivi, perché in grado di orchestrare diversi servizi come parti di un unico processo, un po’ come farebbe un umano passando da un’applicazione all’altra per svolgere un lavoro. Importante sottolineare, come visto, che MCP consente di configurare permessi ristretti e scope precisi per ciascun connettore: ciò attenua i rischi di dare autonomia agli agenti, evitando che un LLM possa causare danni su sistemi critici . Questa combinazione di potenza (accesso a tanti tool) e controllo (limiti e audit centralizzato) è ciò che può sbloccare una nuova generazione di agenti AI affidabili nelle aziende.

-

Standardizzazione delle integrazioni a livello industriale – Se MCP prenderà piede, possiamo aspettarci che sempre più fornitori di software e piattaforme esporranno i propri servizi direttamente tramite connettori MCP ufficiali. In futuro, oltre alle tradizionali API REST/GraphQL, un’azienda tech potrebbe distribuire un piccolo server MCP pronto all’uso per consentire a qualsiasi assistente AI di interfacciarsi con il suo prodotto . Ad esempio, una piattaforma SaaS CRM potrebbe fornire un “MCP connector” che rende disponibili funzioni come getCustomerInfo o createLead conformi allo standard: un’organizzazione che adotta un agente AI dovrà solo installare quel modulo, senza sviluppare nulla da zero. Soluzioni emergenti come Speakeasy stanno già gettando le basi in questa direzione, generando automaticamente codice di server MCP a partire da specifiche OpenAPI esistenti . Questo scenario prospetta un mondo in cui è normale trovare “endpoint MCP” accanto alle API tradizionali, e dove integrare un nuovo servizio nell’ecosistema AI equivale a installare un driver o plugin standard anziché ingegnerizzare una nuova integrazione ogni volta. Il potenziale impatto è enorme: si abbassano drasticamente le barriere per connettere qualsiasi software all’intelligenza artificiale, favorendo la nascita di ecosistemi di agenti interconnessi. Ogni azienda potrebbe scegliere dalla libreria di connector standard quelli pertinenti al proprio stack (dai servizi cloud alle applicazioni on-premise legacy), sapendo che gli agenti AI li potranno usare immediatamente. Si passa così da un paradigma in cui ogni AI è un silos, a un approccio di AI interoperabile, dove varie intelligenze e tool parlano la stessa lingua.

-

Condivisione della conoscenza e collaboratività – MCP facilita anche l’integrazione di fonti di conoscenza trasversali. Come visto, un assistente può combinare informazioni da fonti personali, di team e pubbliche nello stesso contesto . Questo apre possibilità interessanti per la collaborazione uomo-AI: ad esempio, team diversi all’interno di un’azienda possono mettere a disposizione i propri dataset o servizi tramite server MCP (ciascuno con le dovute restrizioni), rendendoli fruibili a un assistente AI comune. L’AI potrebbe fungere da broker intelligente che attinge al knowledge base di diversi reparti per rispondere a domande complesse che richiedono unendo competenze (es. dati di marketing + dati di produzione per un’analisi di supply chain). Inoltre, grazie alla natura modulare, un utente potrebbe “collegare” rapidamente nuove fonti al proprio assistente man mano che emergono esigenze: oggi aggiungo l’integrazione con un nuovo tool di project management, domani scollego l’accesso a un servizio obsoleto, il tutto senza dover riprogettare l’architettura conversazionale. In sostanza, MCP abilita un flusso di conoscenza fluido tra sistemi finora isolati, facendo dell’AI il nodo di raccordo. Questo porta anche benefici in termini di governance: avendo un punto centrale di passaggio (il layer MCP), è più facile applicare regole uniformi su privacy, auditing e conformità quando l’AI accede a dati sensibili . Le organizzazioni possono così abbracciare con più fiducia soluzioni AI pervasive, sapendo di poterle monitorare e controllare meglio rispetto a una giungla di integrazioni non standard.

L’avvento di MCP ci suggerisce un futuro in cui gli assistenti AI saranno componenti omnipresenti e interconnessi nell’ecosistema software, analogamente a come oggi i servizi web comunicano tra loro attraverso protocolli standard come HTTP. Vediamo già interesse e adozione da parte di attori di primo piano: ad esempio, aziende come Block (Square) e tool developer come Zed e Replit sono state tra i primi ad adottare MCP, contribuendo a una community che in pochi mesi ha prodotto centinaia di connettori per ogni sorta di risorsa – da Google Drive ai repository Git .

Questa rapidità di crescita indica che l’industria potrebbe convergere su MCP (o protocolli simili) per evitare di frammentare gli sforzi in mille integrazioni proprietarie. Un ecosistema di agenti AI interconnessi, ognuno specializzato ma capace di collaborare tramite standard comuni, ricorda per certi versi l’evoluzione dei microservizi nel software: piccoli componenti autonomi che lavorano insieme attraverso API ben definite. Allo stesso modo, MCP può favorire una “microservitizzazione” dell’intelligenza artificiale, in cui diverse capacità sono fornite da moduli AI separati ma coordinati. Per utenti e aziende ciò si tradurrà in soluzioni AI più potenti, flessibili e sicure, perché costruite su un’infrastruttura cooperativa anziché su monoliti chiusi.

Un futuro plug-and-play per l’AI

Il Model Context Protocol rappresenta un passo importante verso un’infrastruttura AI scalabile, interoperabile e davvero plug-and-play, in cui aggiungere una nuova capacità a un assistente digitale diventa semplice quanto collegare una periferica a un computer. Grazie a standard aperti come MCP, gli sviluppatori possono concentrarsi sul valore applicativo (logica di business, esperienza utente, strategie di AI) anziché perdere tempo a scrivere integrazioni di basso livello per ogni singolo sistema .

Dal punto di vista strategico, questo significa accelerare la diffusione dell’AI in tutti i settori: riducendo costi e tempi di integrazione, più aziende e prodotti potranno incorporare assistenti e funzioni intelligenti, sapendo di poterli collegare facilmente ai propri dati e processi esistenti. In prospettiva, protocolli come MCP fungeranno da fondamenta comuni su cui costruire ecosistemi AI completi, un po’ come HTTP e REST sono stati le fondamenta su cui è esploso il Web e le API economy.

La standardizzazione porta a effetti di rete: una volta che molti attori adottano lo stesso protocollo, diventa sempre più conveniente per altri aderirvi, creando un circolo virtuoso di compatibilità e innovazione condivisa.

Certo, ci vorrà tempo perché MCP (o alternative analoghe) maturino e vengano adottate su vasta scala, ma la direzione è tracciata. Per chi opera nel campo dell’intelligenza artificiale e della trasformazione digitale, tenere d’occhio queste evoluzioni è fondamentale: abbracciare un approccio modulare e aperto oggi potrebbe fare la differenza nel costruire soluzioni AI future-proof domani. In conclusione, il Model Context Protocol non è solo una nuova tecnologia di integrazione, ma incarna una filosofia di ecosistema – dove AI, dati e strumenti dialogano liberamente.

Questo approccio “a spine intercambiabili” potrà abilitarci a sfruttare l’AI in modo ben più pervasivo e versatile, trasformando davvero l’AI da silos sperimentale a componente infrastrutturale di ogni applicazione moderna . Con protocolli come MCP, l’AI diventa plug-and-play: pronta a connettersi, collaborare e scalare insieme al resto del nostro stack tecnologico.

MCP is not just a technical framework — it’s a philosophy of interconnected intelligence.

Comments are closed